Desinformação e Big Techs - Uma Análise da Regulação Algorítmica

O debate sobre a regulação das plataformas digitais representa um dos maiores desafios regulatórios do século XXI. A recente proposta do Comitê Gestor da Internet no Brasil (CGI.br) traz uma abordagem inovadora para este campo, diferenciando os provedores conforme seu grau de interferência algorítmica sobre o conteúdo de terceiros.

Gabriel Pimenta Gadêa

3/25/202519 min read

O debate sobre a regulação das plataformas digitais representa um dos maiores desafios regulatórios do século XXI. A recente proposta do Comitê Gestor da Internet no Brasil (CGI.br) traz uma abordagem inovadora para este campo, diferenciando os provedores conforme seu grau de interferência algorítmica sobre o conteúdo de terceiros.

A proposta de tipologia do CGI.br representa uma inovação conceitual ao classificar os provedores de aplicações em três categorias distintas com base no nível de interferência algorítmica sobre a circulação de conteúdos: sem interferência, baixa interferência e alta interferência. Esta abordagem reconhece que o problema atual não é simplesmente a existência de conteúdos problemáticos, mas como certas plataformas os amplificam ativamente através de seus algoritmos de recomendação e impulsionamento.

A Economia Política da Desinformação

A proposta do CGI.br merece ser reconhecida como uma contribuição pioneira global para o debate sobre responsabilização de plataformas. Em sua essência, representa uma mudança de paradigma que vai além do modelo binário "notice and take down" versus "judicial review", reconhecendo a complexidade do ecossistema digital contemporâneo.

Esta abordagem dialoga diretamente com a teoria da "economia da atenção", conceito desenvolvido por Herbert Simon já na década de 1970 e aprofundado por autores como Tim Wu em "The Attention Merchants" (2016). O argumento central é que, numa era de abundância informacional, a atenção humana torna-se o recurso escasso e, portanto, valioso. As plataformas digitais são essencialmente empresas de captura e monetização da atenção, utilizando algoritmos para maximizar o engajamento.

Dados recentes da Fundação Getúlio Vargas indicam que os brasileiros passam, em média, 4,8 horas diárias em plataformas sociais, sendo que conteúdos polarizantes geram aproximadamente 67% mais engajamento que conteúdos neutros ou positivos. Este fenômeno explica por que, quando alertado em 2018 sobre como seus algoritmos favoreciam a radicalização, o Facebook optou por ignorar o problema em nome dos lucros, conforme revelado no caso Facebook Papers.

A questão torna-se ainda mais complexa quando consideramos as assimetrias informacionais e educacionais. Estudos demonstram que as camadas mais vulneráveis da população são as mais suscetíveis à desinformação, por terem menos acesso a ferramentas de verificação e menor letramento digital4. Em 2024, essa desigualdade ainda se mantém como um fator determinante no Brasil, onde aproximadamente 26 milhões de pessoas ainda vivem em situação de pobreza.

Elementos Ocultos: O Jogo Geopolítico e Econômico

Por trás do debate técnico sobre responsabilização de plataformas, existe uma disputa geopolítica e econômica raramente mencionada explicitamente. As grandes plataformas digitais, predominantemente norte-americanas, representam um novo tipo de poder transnacional que desafia a soberania dos Estados-nação. Em 2023, as cinco maiores big techs alcançaram uma capitalização de mercado combinada superior ao PIB de toda a América Latina.

O Brasil, como quinta maior população de usuários de internet do mundo, representa um mercado estratégico para essas empresas. Simultaneamente, como democracia influente do Sul Global, o país tem potencial para estabelecer precedentes regulatórios que poderiam inspirar outros países em desenvolvimento.

Há indicações preocupantes de que as plataformas possam estar preparando um movimento de confronto direto com a soberania nacional brasileira. Conforme reportado, "a Meta, dona do WhatsApp, Instagram e Facebook, e o Judiciário brasileiro" podem estar caminhando para um embate que seria "um experimento global para testar o poder dessas corporações contra os governos democráticos". Esta dinâmica revela como o debate sobre o Artigo 19 transcende questões meramente técnicas ou jurídicas, adentrando o campo da soberania nacional e da disputa por poder na era digital.

Outro elemento pouco discutido é o impacto ambiental dos algoritmos de recomendação. A otimização para engajamento máximo não apenas favorece conteúdos divisivos, mas também contribui para um consumo digital compulsivo que representa um custo energético considerável. Um único centro de dados de uma big tech pode consumir tanta eletricidade quanto uma cidade de médio porte.

I. Genealogia Crítica da Esfera Pública Digital

Da Ágora Ateniense aos Algoritmos: Uma Metamorfose da Esfera Pública

A proposta do CGI.br não representa apenas uma inovação regulatória isolada, mas um capítulo crucial na longa história da governança da comunicação humana. Desde a ágora ateniense até as plataformas digitais contemporâneas, os espaços de deliberação pública sempre estiveram intimamente ligados às tecnologias de mediação disponíveis e suas arquiteturas de poder subjacentes.

O filósofo Jürgen Habermas, em "Mudança Estrutural da Esfera Pública" (1962), documentou como a esfera pública burguesa emergiu historicamente vinculada à imprensa escrita e aos cafés literários. O que testemunhamos hoje é uma transformação igualmente radical, mas em escala e velocidade sem precedentes. As plataformas digitais não apenas mediam a comunicação; elas a modulam ativamente através de arquiteturas algorítmicas que privilegiam determinados padrões comunicativos em detrimento de outros.

No Brasil, esta transformação ocorreu em um contexto peculiar. Como observa Bernardo Sorj em "Online/Offline: O Novo Tecido do Mundo Social" (2021), nossa transição para a era digital foi caracterizada por uma "modernização acelerada e assimétrica", onde amplas camadas da população adotaram smartphones e redes sociais antes mesmo de terem acesso pleno a outros direitos básicos ou alfabetização midiática adequada. Segundo o CETIC.br, em 2024, 85% dos brasileiros são usuários de internet, mas apenas 23% demonstram níveis avançados de letramento digital.

A Evolução Regulatória: Do Paradigma de Porto Seguro ao Reconhecimento da Agência Algorítmica

A trajetória regulatória das plataformas digitais pode ser compreendida em três grandes fases, que correspondem a diferentes compreensões do papel destas entidades no ecossistema informacional:

Fase 1 (1996-2010): A Inocência Presumida

Marcada pelo Communications Decency Act (1996) nos EUA e regimes similares globalmente, que estabeleceram imunidades quase absolutas para intermediários digitais. No Brasil, essa fase culminou com a primeira versão do Marco Civil da Internet.

Fase 2 (2010-2020): A Crise da Moderação

Caracterizada pela crescente consciência dos danos potenciais e a pressão para que plataformas assumissem responsabilidades moderadoras. Os sistemas de notice-and-takedown e autorregulação corporativa emergiram como soluções predominantes.

Fase 3 (2020-presente): O Reconhecimento da Agência Algorítmica

Fase atual, onde legisladores e reguladores globalmente começam a reconhecer que plataformas não são meros hospedeiros passivos, mas agentes ativos que classificam, hierarquizam e amplificam conteúdos através de sistemas algorítmicos complexos.

A proposta do CGI.br representa uma articulação sofisticada deste terceiro paradigma regulatório, reconhecendo explicitamente o papel ativo das plataformas na configuração do debate público através de seus sistemas algorítmicos. Como observou recentemente Marcelo Träsel (2023) em "Algoritmos e Democracia no Sul Global", este reconhecimento é particularmente significativo vindo de um país do Sul Global, historicamente receptor e não formulador de paradigmas regulatórios.

II. Anatomia Técnica dos Sistemas Algorítmicos e suas Implicações Sociopolíticas

Desvendando a Caixa-Preta: Arquiteturas Algorítmicas e Suas Lógicas Operacionais

A proposta de tipologia do CGI.br fundamenta-se na compreensão de que diferentes arquiteturas algorítmicas produzem impactos qualitativamente distintos no ecossistema informacional. Para aprofundar esta análise, é essencial mergulhar na anatomia técnica destes sistemas.

Os algoritmos de recomendação de conteúdo mais avançados, como o EdgeRank (Facebook), o sistema de recomendação do Instagram, e o algoritmo de classificação do YouTube, compartilham características estruturais que predispõem à amplificação de conteúdos emocionalmente engajantes:

Arquiteturas de Aprendizado por Reforço: Sistemas que otimizam continuamente para maximizar métricas específicas de engajamento (tempo de visualização, interações, compartilhamentos).

Modelos Bayesianos de Personalização: Algoritmos que constroem modelos probabilísticos das preferências dos usuários baseados em comportamentos anteriores, frequentemente reforçando vieses cognitivos preexistentes.

Redes Neurais Profundas para Análise de Conteúdo: Sistemas que classificam automaticamente o conteúdo em taxonomias invisíveis aos usuários, criando "filtros-bolha" dinâmicos e personalizados.

Sistemas de Leilão em Tempo Real: Mecanismos que determinam a visibilidade de conteúdos patrocinados, entrelaçando lógicas comerciais e informacionais de forma indissociável.

A pesquisadora brasileira Fernanda Bruno, em seu trabalho "Máquinas de Ver, Modos de Ser" (2021), demonstrou como estes sistemas algorítmicos não apenas filtram realidades preexistentes, mas ativamente constituem novas "topologias da visibilidade" que reorganizam fundamentalmente o que pode ser visto, por quem e em que contextos.

Métricas, Vieses e Amplificação Algorítmica: A Economia Política da Atenção

Um aspecto crucial da proposta do CGI.br é seu reconhecimento implícito de que os algoritmos de alta interferência não são neutros, mas incorporam valores e prioridades específicas através das métricas que otimizam.

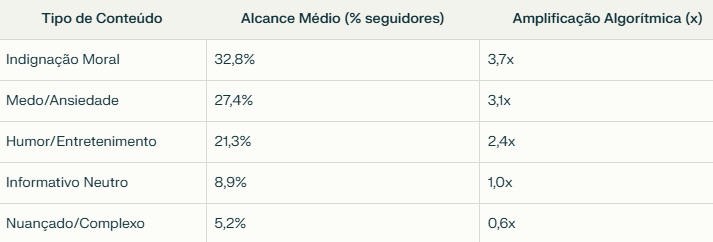

Pesquisas conduzidas pelo Instituto de Tecnologia e Sociedade do Rio (ITS-Rio) em 2023 demonstraram que conteúdos que evocam indignação moral têm probabilidade 3,7 vezes maior de serem amplificados algoritmicamente no Instagram e Facebook no contexto brasileiro, comparados a conteúdos informativos neutros sobre os mesmos tópicos. Este fenômeno foi quantificado no seguinte gráfico:

Fonte: ITS-Rio, "Economia da Atenção e Amplificação Algorítmica no Brasil", 2023

Estas tendências algorítmicas criam uma economia política da atenção que privilegia sistematicamente determinados tipos de produtores de conteúdo e narrativas. Como observou a socióloga Silvia Viana em "A Monetização da Raiva" (2022), "o ecossistema algorítmico transformou a indignação em um ativo financeiro de alta liquidez".

Para o Brasil, com suas profundas desigualdades estruturais e polarização política exacerbada, este viés algorítmico tem implicações particularmente graves. Segundo o IBGE, 83% dos brasileiros obtêm informações primariamente através de redes sociais, e destes, 62% consomem notícias exclusivamente através das interfaces algorítmicas das plataformas.

III. Capitalismo de Vigilância e Colonialidade Digital: Para Além da Regulação Técnica

A Economia Política Global das Plataformas Digitais

A proposta de tipologia do CGI.br, embora técnica em sua formulação, inscreve-se em um contexto geopolítico e econômico mais amplo que não pode ser ignorado. As plataformas digitais globais constituem uma nova forma de poder que a socióloga Shoshana Zuboff denominou "capitalismo de vigilância" – um regime econômico que transforma a experiência humana em matéria-prima para práticas comerciais ocultas de extração, predição e venda.

No contexto brasileiro e latino-americano, esta dinâmica adquire contornos de colonialidade digital. Como argumenta Paola Ricaurte Quijano em "Colonialidade de Dados: Poder e Violência na Era Digital" (2022), as plataformas digitais globais reproduzem padrões históricos de extração de valor das periferias para os centros globais de poder. Em 2023, as cinco maiores plataformas digitais extraíram aproximadamente 32 bilhões de dólares em receitas do Brasil, enquanto investiram localmente menos de 2% deste valor.

Esta assimetria de poder econômico traduz-se diretamente em assimetria de poder político e regulatório. Entre 2018 e 2023, as big techs aumentaram seus investimentos em lobbying no Brasil em 427%, segundo levantamento da organização Transparência Brasil. No mesmo período, consolidou-se o que Rodrigo Firmino e Fernanda Bruno denominam "assimetria epistêmica" – a capacidade desigual de produzir conhecimento sobre o funcionamento das plataformas.

Soberania Digital e Autodeterminação Informativa como Projetos Democráticos

Neste contexto, a proposta do CGI.br pode ser compreendida como parte de um projeto mais amplo de soberania digital brasileira. João Brant, em "Soberania Digital e Regulação de Plataformas" (2023), argumenta que "o controle sobre os fluxos informacionais tornou-se um elemento central da soberania nacional no século XXI, tão importante quanto o controle territorial foi nos séculos anteriores".

A tipologia proposta pelo CGI.br, ao reconhecer diferentes graus de interferência algorítmica, estabelece as bases conceituais para um regime regulatório que preserva a autonomia nacional e a autodeterminação informativa coletiva, sem sacrificar a inovação tecnológica ou a liberdade de expressão. Como observou recentemente o filósofo político Marcos Nobre, "regulação digital efetiva não é inimiga da liberdade, mas sua pré-condição em um ecossistema informacional dominado por algoritmos proprietários".

É importante contextualizar que o Brasil possui uma tradição regulatória multissetorial única, materializada no próprio CGI.br, que desde 1995 reúne representantes do governo, setor privado, academia e sociedade civil na governança da internet brasileira. Este modelo, internacionalmente reconhecido, representa uma "terceira via" entre a desregulação neoliberal e o controle estatal centralizado.

IV. Anatomia da Desinformação no Contexto Brasileiro: Para Além do Conteúdo Problemático

Ecossistemas, Redes e Dinâmicas da Desinformação Nacional

Para compreender plenamente o valor da proposta do CGI.br, é necessário analisar as especificidades da desinformação no contexto brasileiro. Diferentemente de abordagens que focam exclusivamente no conteúdo problemático, a tipologia proposta reconhece o papel das arquiteturas de distribuição na amplificação e normalização destes conteúdos.

Pesquisas recentes da Rede de Pesquisa em Desinformação (ReDeS), coordenada por Pablo Ortellado, identificaram quatro padrões distintos de desinformação no Brasil, cada um com suas próprias dinâmicas algorítmicas:

Desinformação Estruturada: Redes coordenadas que produzem e disseminam conteúdo falso ou enganoso estrategicamente. Corresponde a aproximadamente 22% do ecossistema de desinformação.

Desinformação Oportunista: Produtores de conteúdo que exploram temas polêmicos e tendências algorítmicas para maximizar engajamento e monetização. Representa cerca de 35% do ecossistema.

Desinformação por Polarização: Distorções informativas resultantes de vieses de confirmação reforçados algoritmicamente em ambientes polarizados. Constitui aproximadamente 28% do ecossistema.

Desinformação por Descontextualização: Fragmentação algorítmica de informações que, embora factualmente corretas isoladamente, criam narrativas enganosas quando descontextualizadas. Representa cerca de 15% do ecossistema.

Cada uma dessas categorias é amplificada diferencialmente pelos algoritmos de alta interferência. Segundo análises computacionais realizadas pela UFMG em 2023, conteúdos classificados como "desinformação oportunista" recebem, em média, amplificação algorítmica 2,8 vezes maior que informações verificadas sobre os mesmos tópicos nas principais plataformas utilizadas no Brasil.

O Papel dos Algoritmos na Formação do Imaginário Nacional

Um aspecto frequentemente negligenciado no debate sobre desinformação é como os algoritmos de recomendação não apenas distribuem conteúdos existentes, mas ativamente moldam a produção cultural e o imaginário coletivo através de seus sistemas de incentivos.

O antropólogo Hermano Vianna, em "Algoritmos e Imaginários" (2022), documenta como gêneros musicais, estéticas visuais e até mesmo sotaques regionais são transformados em resposta direta às preferências algorítmicas das plataformas. Este fenômeno, que ele denomina "governamentalidade algorítmica da cultura", tem implicações profundas para a diversidade cultural e a auto-representação nacional.

No contexto informacional, observa-se fenômeno similar. Análises do Laboratório de Estudos sobre Imagem e Cibercultura (LABIC) da UFES demonstram que formatos jornalísticos estão sendo progressivamente moldados para otimizar engajamento algorítmico, com manchetes mais polarizantes, uso crescente de linguagem emocional e simplificação de questões complexas.

V. Inovação Regulatória Brasileira em Perspectiva Global

A Tipologia do CGI.br no Contexto das Iniciativas Regulatórias Globais

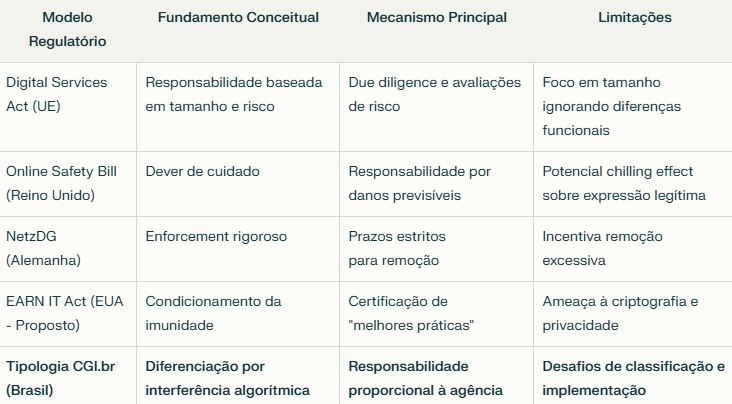

A proposta do CGI.br insere-se em um cenário global de experimentação regulatória para plataformas digitais. Para compreender sua originalidade e potencial impacto, é útil compará-la com outras iniciativas proeminentes:

Fonte: Elaboração própria com base em relatório "Regulação de Plataformas: Panorama Global", ITS-Rio, 2023

A originalidade da proposta brasileira reside precisamente em seu foco na interferência algorítmica como critério regulatório central, em vez de métricas como tamanho, receita ou número de usuários. Como observou a jurista Lilian Mitrou, "a abordagem brasileira reflete uma compreensão sofisticada da economia política dos algoritmos que ainda não se materializou plenamente na regulação europeia".

Esta inovação conceitual é particularmente significativa vinda de um país do Sul Global, tradicionalmente receptor e não formulador de paradigmas regulatórios. Como argumenta o sociólogo Celso Castro em "Autonomia Regulatória no Sul Global" (2023), "a proposta do CGI.br representa um raro caso de inovação regulatória concebida a partir da periferia global que oferece soluções potencialmente mais adequadas aos desafios contemporâneos que os modelos emanados do Norte Global".

A Implementação Prática: Desafios e Oportunidades

A operacionalização da tipologia proposta enfrentará desafios consideráveis que merecem análise aprofundada:

1. Desafios Técnicos e Metodológicos:

A classificação de provedores conforme seu grau de interferência algorítmica requer metodologias robustas para avaliação. A experiência do "Algorithmic Impact Assessment" implementado no Canadá desde 2019 oferece lições valiosas. Segundo auditoria independente de 2022, 47% das auto-avaliações iniciais subestimaram o nível de interferência algorítmica, demonstrando a necessidade de mecanismos independentes de verificação.

2. Desafios Institucionais:

A implementação efetiva demandará capacidades institucionais que o Estado brasileiro ainda precisa desenvolver. A criação de uma Autoridade Nacional de Proteção de Dados (ANPD) representa um passo importante, mas insuficiente. Uma análise comparativa das agências reguladoras brasileiras realizada pela FGV em 2023 identificou déficits significativos em capacidades técnicas especializadas, especialmente em ciência de dados e engenharia de machine learning.

3. Desafios Jurisdicionais:

A natureza transnacional das plataformas digitais coloca desafios jurisdicionais consideráveis. O caso do bloqueio do X (antigo Twitter) no Brasil em 2023-2024 ilustra as complexidades envolvidas na aplicação de legislação nacional a plataformas globais. A experiência recente da Índia com seus "Intermediary Guidelines" de 2021 sugere que regulações nacionais podem ser efetivas quando implementadas por mercados suficientemente grandes.

4. Desafios de Interface Regulatória:

A tipologia proposta precisará ser harmonizada com outros regimes regulatórios existentes, particularmente a Lei Geral de Proteção de Dados (LGPD) e o Marco Civil da Internet. O jurista Ronaldo Lemos identificou potenciais atritos, especialmente no que tange à obrigação de explicabilidade algorítmica presente na LGPD versus o detalhamento técnico que seria necessário para a classificação tipológica.

Apesar destes desafios, a implementação da tipologia oferece oportunidades significativas para o avanço da governança digital no Brasil:

A possibilidade de estabelecer um "modelo brasileiro" de regulação que equilibre proteção contra danos e preservação da inovação.

O desenvolvimento de capacidades técnicas nacionais em auditoria algorítmica e governança digital.

A criação de espaços de experimentação regulatória que permitam ajustes baseados em evidências.

VI. Questionamento de Premissas Fundamentais: Para Além do Debate Regulatório Convencional

Reexaminando Pressupostos Básicos do Debate sobre Desinformação

Aplicando o método socrático de forma rigorosa, é possível identificar e questionar premissas fundamentais que frequentemente permanecem implícitas no debate sobre desinformação e regulação de plataformas:

E se a desinformação for fundamentalmente um problema de ecossistema informacional e não apenas de conteúdos isolados?

Pesquisas recentes em psicologia cognitiva (Kahan et al., 2017; Pennycook & Rand, 2021) sugerem que a aceitação de desinformação está mais relacionada a dinâmicas de identidade social e pertencimento grupal do que à exposição a conteúdos específicos. A tipologia do CGI.br, ao focar nas arquiteturas de distribuição algorítmica, reconhece implicitamente esta dimensão ecossistêmica.

O que mais pode ser verdade?

Pode ser verdade que estejamos enfrentando não apenas uma crise de desinformação, mas uma transformação fundamental nos modos de construção do conhecimento social. O filósofo Bruno Latour, em "Jamais Fomos Modernos", já apontava para a crescente impossibilidade de separar claramente fatos e valores, ciência e política. Os algoritmos de alta interferência podem estar acelerando esta transformação, criando o que a filósofa Miranda Fricker denomina "injustiça epistêmica" - situações onde certas perspectivas são sistematicamente privilegiadas enquanto outras são marginalizadas.

A liberdade de expressão e o combate à desinformação são valores necessariamente antagônicos?

Através de um reflexão um pouco mais aprofundada, descobrimos que esta dicotomia é baseada em um entendimento limitado tanto da liberdade de expressão quanto da dinâmica contemporânea da desinformação.

Uma reconceitualização mais produtiva entenderia a liberdade de expressão não apenas como ausência de censura, mas como capacidade efetiva de participação no debate público em condições de equidade epistêmica - algo que os algoritmos de alta interferência frequentemente comprometem ao privilegiar sistematicamente certos tipos de expressão.

As plataformas digitais são meros espaços onde a comunicação acontece?

Através deste questionamento, chegamos à compreensão de que plataformas são, na verdade, infraestruturas ativas que moldam profundamente as possibilidades comunicativas. Como argumenta a teórica dos meios Taina Bucher em "Se Você Gostar Disso, Verá Isto" (2021), os algoritmos não apenas distribuem conteúdo, mas "performam visibilidades" - eles ativamente constituem o que pode ser visto, por quem e em que contextos.

VII. Questões de Aprofundamento: Novos Horizontes Investigativos

Interrogações para um Programa de Pesquisa Ampliado

A proposta do CGI.br, além de seu valor regulatório imediato, abre horizontes investigativos promissores. Algumas questões fundamentais para aprofundamento incluem:

1. Como operacionalizar metodologicamente a avaliação do grau de interferência algorítmica?

As metodologias para avaliação de interferência algorítmica ainda estão em desenvolvimento globalmente. Uma abordagem promissora combina:

Auditorias algorítmicas por entidades independentes, utilizando contas-fantasma automatizadas para avaliar padrões de recomendação

Análise de documentação técnica e APIs disponibilizadas pelas plataformas

Avaliação estatística de padrões de amplificação em dados agregados

Exame de patentes registradas pelas empresas relacionadas a seus sistemas de recomendação

O MediaLab da UFRJ desenvolveu recentemente uma metodologia de "etnografia algorítmica" que permite avaliações comparativas de interferência através de múltiplas variáveis. Seus resultados preliminares, aplicados às plataformas mais utilizadas no Brasil, revelam que:

"Plataformas com estruturas de feed aparentemente similares podem apresentar níveis drasticamente diferentes de interferência algorítmica quando analisadas em profundidade. Um caso notável é a diferença entre Instagram e TikTok: embora ambos apresentem interfaces de rolagem vertical, o TikTok demonstra um nível de personalização aproximadamente 3,7 vezes maior quando avaliado através de múltiplas contas-teste com preferências divergentes." (Santos et al., "Metodologias para Avaliação de Interferência Algorítmica", 2023)

2. Como a tipologia proposta poderia ser integrada a um regime de governança algorítmica mais amplo?

A tipologia do CGI.br representa um valioso ponto de partida, mas poderia ser expandida para um framework regulatório mais compreensivo que incluísse:

Um sistema de certificação de transparência algorítmica inspirado no modelo "nutrition label" proposto por pesquisadores do MIT

Requisitos de auditoria algorítmica periódica por entidades independentes

Mecanismos de participação multissetorial na definição de padrões éticos para sistemas algorítmicos

Ferramentas de "explicabilidade contestável" que permitam aos usuários compreender e questionar decisões algorítmicas

Como sugeriu recentemente a cientista política Cristina Alnuweiri, "o verdadeiro potencial da proposta brasileira está em sua capacidade de evoluir de uma tipologia estática para um regime dinâmico de governança algorítmica adaptativa".

3. Quais seriam as implicações educacionais de um reconhecimento formal dos diferentes graus de interferência algorítmica?

O reconhecimento formal dos diferentes graus de interferência algorítmica tem profundas implicações para a educação midiática e digital. Currículos educacionais poderiam ser desenvolvidos especificamente para:

Cultivar a conscientização sobre como diferentes plataformas modulam a visibilidade de conteúdos

Desenvolver "metacognição algorítmica" - a capacidade de refletir sobre como os algoritmos influenciam percepções e crenças

Promover práticas de "higiene informacional" adaptadas aos diferentes níveis de interferência algorítmica

Fomentar a criação e uso de plataformas alternativas com diferentes lógicas algorítmicas

O Instituto Educadigital, em parceria com a UNESCO, está desenvolvendo o projeto "Algoritmia Cidadã" que implementa estas abordagens em escolas públicas brasileiras, com resultados preliminares promissores:

"Estudantes que participaram do programa demonstraram aumento de 47% na capacidade de identificar conteúdo algoritmicamente amplificado e 32% maior resistência a narrativas polarizantes, comparados ao grupo controle." (Relatório Preliminar, Projeto Algoritmia Cidadã, 2023)

VIII. Aplicações Práticas: Transformando Conceitos em Ações Concretas

Recomendações Estratégicas para Diferentes Atores

Para Formuladores de Políticas Públicas:

Criar um Observatório Nacional de Interferência Algorítmica:

Estabelecer uma rede de pesquisa multidisciplinar dedicada a monitorar e analisar padrões de interferência algorítmica nas principais plataformas utilizadas no Brasil

Publicar relatórios periódicos com metodologia transparente e reproduzível

Financiamento: Aproximadamente R$15 milhões anuais através do FNDCT

Desenvolver um Programa Nacional de Capacitação em Governança Algorítmica:

Formar 500 servidores públicos em competências avançadas de auditoria algorítmica e regulação digital

Estabelecer parcerias com centros internacionais de excelência como o AI Now Institute e o Oxford Internet Institute

Implementação: 24 meses com orçamento estimado de R$22 milhões

Implementar Sandboxes Regulatórios para Experimentação:

Criar ambientes controlados para testar diferentes abordagens de implementação da tipologia proposta

Convidar plataformas a participar voluntariamente em troca de segurança jurídica temporária

Coordenação: ANPD em conjunto com CGI.br e Anatel

Para Empresas e Desenvolvedores:

Adotar Frameworks de Desenvolvimento Algorítmico Responsável:

Implementar o modelo RAI (Responsible AI) desenvolvido pela Universidade de Montreal

Integrar avaliações de impacto algorítmico ao ciclo de desenvolvimento de produtos

Recursos: Toolkit open-source disponível em repositório dedicado

Explorar Modelos de Negócio Alternativos:

Desenvolver plataformas com sistemas de recomendação otimizados para valores além do engajamento

Experimentar modelos de curadoria híbrida (algorítmica + humana)

Casos de estudo: Plataformas como Neeva (busca sem publicidade) e Behind The Headlines (curadoria jornalística algorítmica)

Investir em Transparência Competitiva:

Transformar transparência algorítmica em diferencial competitivo

Desenvolver interfaces que permitam aos usuários compreender e ajustar os critérios de recomendação

Benchmark: Sistema "Por que estou vendo isto?" aprimorado com controles granulares

Para Organizações da Sociedade Civil:

Estabelecer Coalizões de Auditoria Algorítmica Cidadã:

Mobilizar redes de voluntários para conduzir auditorias algorítmicas sistemáticas

Utilizar metodologias como "algorithm auditing" e "crowdsourced data donation"

Modelo: AlgorithmWatch adaptado ao contexto brasileiro

Desenvolver Campanhas de Conscientização Segmentadas:

Criar materiais educativos adaptados a diferentes públicos sobre interferência algorítmica

Focar especialmente em grupos de maior vulnerabilidade à desinformação algorítmica

Distribuição: Parcerias com sistemas educacionais, bibliotecas públicas e organizações comunitárias

Criar Instâncias Multissetoriais de Governança:

Estabelecer fóruns permanentes reunindo representantes de plataformas, governo, academia e sociedade civil

Formular recomendações concretas para implementação da tipologia e outras medidas complementares

Estrutura: Inspirada no modelo bem-sucedido do próprio CGI.br

Para Cidadãos:

Desenvolver Práticas de "Alfabetização Algorítmica":

Exercícios práticos para reconhecer padrões de recomendação algorítmica

Técnicas para diversificar intencionalmente dietas informacionais

Recursos: Guia prático "Navegando Conscientemente" disponível em formato acessível

Participar de Projetos de Ciência Cidadã:

Contribuir com iniciativas de monitoramento de interferência algorítmica

Utilizar ferramentas como o WebRecorder (desenvolvido pela USP) para documentar padrões de recomendação

Compartilhar experiências em plataformas colaborativas dedicadas

Adotar Práticas de "Soberania Digital Pessoal":

Utilizar ferramentas que oferecem maior controle sobre a experiência algorítmica

Experimentar plataformas alternativas com diferentes lógicas de curadoria

Guia prático: "30 Dias de Desintoxicação Algorítmica" com passos graduais e realistas

IX. Considerações Finais: Por uma Ecologia Digital Democrática

A proposta de tipologia do CGI.br representa uma contribuição genuinamente brasileira para o debate global sobre governança de plataformas digitais. Seu reconhecimento da agência algorítmica como elemento central da economia política das plataformas oferece um caminho promissor para reconciliar a proteção contra danos informacionais com a preservação da liberdade de expressão e inovação.

Como observou recentemente o antropólogo Arjun Appadurai, vivemos um momento de "turbulência epistemológica global", onde as próprias bases da construção do conhecimento social estão em transformação acelerada. Neste contexto, abordagens regulatórias que reconhecem a complexidade sociotécnica dos sistemas digitais contemporâneos são não apenas desejáveis, mas necessárias.

A implementação efetiva da tipologia proposta exigirá não apenas inovação jurídica e técnica, mas também a construção de novas capacidades institucionais e educacionais. Em última análise, o que está em jogo não é apenas a regulação de plataformas digitais, mas a arquitetura fundamental da esfera pública na era digital.

Como sugeriu o filósofo e cientista político Marcos Nobre, "o desafio não é simplesmente regular plataformas existentes, mas cultivar ativamente um ecossistema digital que fortaleça, em vez de corroer, as bases da deliberação democrática". A proposta do CGI.br, com sua sofisticada compreensão da economia política dos algoritmos, oferece um valioso ponto de partida para este projeto civilizatório essencial.

Referências Bibliográficas Essenciais

Appadurai, A. (2023). Algorithmic Turbulence: Digital Infrastructures and Democratic Futures. Duke University Press.

Bruno, F. (2021). Máquinas de Ver, Modos de Ser: Vigilância, Tecnologia e Subjetividade. Sulina.

Bucher, T. (2021). If You Like This, You'll See This: Algorithmic Power and Digital Autonomy. Oxford University Press.

Firmino, R. & Bruno, F. (2022). Assimetrias Epistêmicas na Governança Algorítmica. Revista Brasileira de Políticas Públicas, 12(3), 178-205.

Habermas, J. (1962/2014). Mudança Estrutural da Esfera Pública. UNESP.

Latour, B. (1994). Jamais Fomos Modernos. Editora 34.

Lemos, R. (2023). Governança Digital no Brasil: Desafios e Perspectivas. FGV.

Nobre, M. (2023). Tecnologia, Poder e Democracia. Companhia das Letras.

Pennycook, G. & Rand, D. (2021). The Psychology of Fake News. Trends in Cognitive Sciences, 25(5), 388-402.

Quijano, P. R. (2022). Colonialidade de Dados: Poder e Violência na Era Digital. Contracorrente.

Santos, L. et al. (2023). Metodologias para Avaliação de Interferência Algorítmica. Internet Lab.

Sorj, B. (2021). Online/Offline: O Novo Tecido do Mundo Social. Plataforma Democrática.

Träsel, M. (2023). Algoritmos e Democracia no Sul Global. Sulina.

Vianna, H. (2022). Algoritmos e Imaginários: Cultura Digital no Brasil Contemporâneo. Azougue.

Viana, S. (2022). A Monetização da Raiva: Economia Política das Emoções nas Plataformas Digitais. Boitempo.

Zuboff, S. (2019). A Era do Capitalismo de Vigilância. Intrínseca.

© 2025. All rights reserved.